Xiaomi MiMo-7B: KI-Revolution mit 7 Milliarden Parametern

Xiaomi MiMo-7B: Ein 7 Milliarden Parameter-Sprachmodell, das Giganten in den Schatten stellt

Xiaomi hat im April 2025 die Welt der Künstlichen Intelligenz mit dem MiMo-7B erschüttert. Dieses Open-Source-Sprachmodell (LLM) mit nur 7 Milliarden Parametern übertrifft in wichtigen Benchmarks deutlich größere Konkurrenten wie OpenAIs o1-mini und Alibabas Qwen-32B – und das im Bereich logisches, mathematisches und programmiertechnisches Denken. Dieser Artikel beleuchtet die innovativen Technologien hinter MiMo-7B, seine herausragenden Leistungen und sein immenses Potential für die Zukunft der KI.

Was ist MiMo-7B?

MiMo-7B ist eine Familie von Sprachmodellen, die vom Xiaomi Big Model Core Team entwickelt wurde, einer spezialisierten KI-Forschungs- und Entwicklungsabteilung. Im Gegensatz zu vielen LLMs, die auf allgemeine Konversationen ausgerichtet sind, konzentriert sich MiMo-7B auf anspruchsvolles logisches, mathematisches und programmiertechnisches Denken. Die Kernkompetenzen liegen in:

- Mathematisches Denken: Lösung komplexer mathematischer Probleme, von Algebra bis hin zu universitären Beweisführungen.

- Codegenerierung: Erstellung und Fehlersuche von Code in verschiedenen Programmiersprachen.

- Logisches Denken: Bewältigung von Aufgaben, die logische Planung und die Lösung strukturierter Probleme erfordern.

Der überraschende Erfolg von MiMo-7B liegt in seiner Effizienz: Mit nur 7 Milliarden Parametern erreicht es ein vergleichbares Leistungsniveau wie deutlich größere Modelle (mit bis zu 32 Milliarden Parametern). Dies ist auf innovative Trainings- und Optimierungsstrategien zurückzuführen. Xiaomi hat vier Open-Source-Versionen (Lizenz: Apache 2.0) auf Hugging Face und GitHub veröffentlicht:

- MiMo-7B-Base: Das Basismodell, das von Grund auf mit Fokus auf logische Muster trainiert wurde.

- MiMo-7B-SFT: Durch Supervised Fine-Tuning (SFT) für höhere Genauigkeit optimiert.

- MiMo-7B-RL-Zero: Aus dem Basismodell mittels Reinforcement Learning (RL) trainiert.

- MiMo-7B-RL: Die fortschrittlichste Version, mit RL aus dem SFT-Modell optimiert und mit den besten Ergebnissen in Mathematik und Codegenerierung.

Schlüsselinnovationen von MiMo-7B

Der Erfolg von MiMo-7B basiert auf einem ganzheitlichen Ansatz, der sowohl das Pre-Training als auch das Fine-Tuning optimiert. Das Modell bricht mit dem Dogma, dass massive Modelle für komplexe Aufgaben unerlässlich sind.

Pre-Training: Fokus auf logisches Denken

Xiaomi hat MiMo-7B von Grund auf mit dem Fokus auf die „Dichte von Denk-Mustern“ entwickelt. Im Gegensatz zu Modellen, die auf allgemeinen Datensätzen basieren, wurde der Datenpipeline von Xiaomi optimiert:

- Hochwertige Daten: MiMo-7B-Base wurde mit 25 Billionen Tokens trainiert, wovon 200 Milliarden speziell auf logisches Denken ausgerichtet waren. Eine dreistufige Datenmischstrategie wurde eingesetzt, die den Anteil an mathematischen und programmiertechnischen Inhalten schrittweise auf 70% erhöhte, ergänzt durch 10% synthetisch erzeugte Problemlösungsdaten.

- Multi-Token Prediction (MTP): MiMo-7B wurde nicht nur darauf trainiert, das nächste Wort vorherzusagen, sondern auch mehrere Tokens gleichzeitig, was das Kontextverständnis verbessert und die Inferenz beschleunigt.

- Mehrdimensionales Filtern: Xiaomi verbesserte die Text-Extraktionswerkzeuge und setzte Filter ein, um logisch reiche Beispiele zu konzentrieren und sicherzustellen, dass das Modell von Anfang an komplexen Mustern ausgesetzt war.

Fine-Tuning: Innovatives Reinforcement Learning

Reinforcement Learning (RL) ist der Schlüssel zum außergewöhnlichen Leistungsvermögen von MiMo-7B-RL. Xiaomi implementierte dabei mehrere fortschrittliche Techniken:

- Kuratierter Datensatz: 130.000 mathematische und programmiertechnische Aufgaben, die durch regelbasierte Systeme verifiziert wurden, um Genauigkeit und Qualität zu gewährleisten. Jedes Problem wurde nach Schwierigkeitsgrad kategorisiert, um das Training zu optimieren.

- Schwierigkeitsgrad-basierte Belohnungen: Um das Problem „spärlicher Belohnungen“ bei komplexen Aufgaben zu lösen, führte Xiaomi ein System von „schwierigkeitsgrad-getriebenen Belohnungen“ (Test Difficulty Driven Reward) ein. Dieses System vergibt differenziertere Punktzahlen für Code-Probleme, belohnt Teillösungen und verbessert die Modelloptimierung.

- Daten-Resampling: Um das Training zu stabilisieren, implementierte Xiaomi eine Strategie zum Resampling einfacherer Probleme, wodurch die Effizienz des Samplings und der Policy-Updates in den letzten RL-Phasen verbessert wurde.

- Seamless Rollout Engine: Xiaomi entwickelte einen „Seamless Rollout Engine“, der die Trainingsgeschwindigkeit um das 2,29-fache und die Validierung um das 1,96-fache erhöhte, die Ausfallzeiten der GPUs reduzierte und die Inferenz optimierte.

MiMo-VL-7B: Ein Sprung zum multimodalen Denken

Zusätzlich zur MiMo-7B-Familie veröffentlichte Xiaomi MiMo-VL-7B, ein Vision-Language-Modell (VLM), das Denkfähigkeiten mit visueller Verarbeitung kombiniert. Dieses Modell beinhaltet:

- Einen ViT-Encoder mit nativer Auflösung, um visuelle Details zu erhalten.

- Einen MLP-Projektor für eine effiziente Ausrichtung zwischen Sicht und Sprache.

- Ein vierstufiges Training, das das Aufwärmen des Projektors, die Ausrichtung von Sicht und Sprache, das multimodale Pre-Training und das überwachte Fine-Tuning umfasst.

- Einen Mixed On-policy Reinforcement Learning (MORL)-Rahmen, der Belohnungssignale für die Wahrnehmungspräzision, logisches Denken und menschliche Präferenzen integriert.

MiMo-VL-7B-RL erzielte die höchste Elo-Bewertung unter den Open-Source Vision-Language-Modellen und übertraf nach internen Bewertungen mit GPT-4o Modelle mit bis zu 72 Milliarden Parametern.

Leistung von MiMo-7B: Benchmarks sprechen für sich

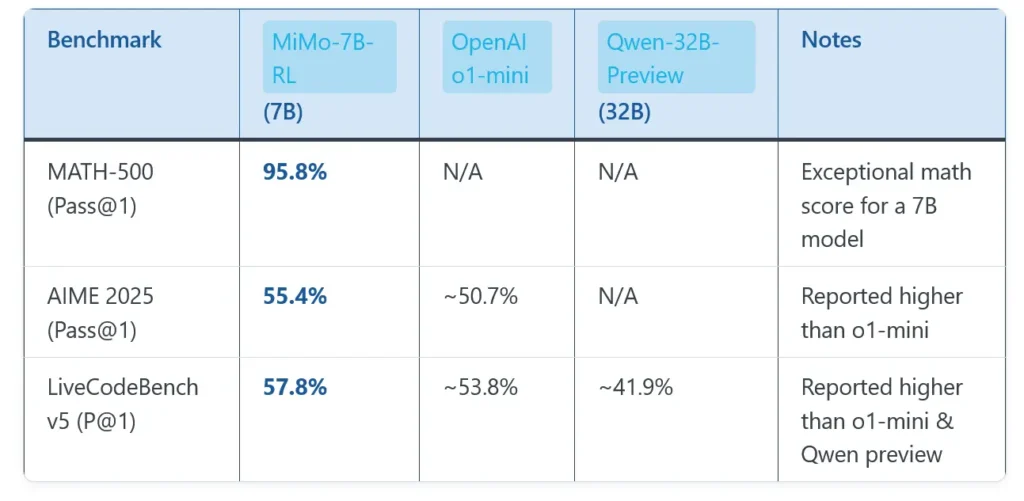

MiMo-7B-RL zeigt in standardisierten Tests herausragende Leistungen und übertrifft größere Modelle in spezifischen Aufgaben:

Mathematik:

- MATH-500: 95,8% Genauigkeit bei der ersten Antwort (Pass@1).

- AIME 2024: 68,2% Pass@1 (Durchschnitt von 32 Ausführungen).

- AIME 2025: 55,4% Pass@1, übertrifft DeepSeek R1 (79,8%) nach Skalierung des SFT-Datensatzes auf 6 Millionen Instanzen.

Programmierung:

- LiveCodeBench v5: 57,8% Pass@1.

- LiveCodeBench v6: 49,3% Pass@1.

Allgemeines Denken:

- GPQA Diamond: 54,4% Pass@1.

- IF-Eval (Prompt Strict): 61,0% Pass@1.

Diese Ergebnisse unterstreichen die Fähigkeit von MiMo-7B, mit Modellen wie OpenAI o1-mini und Alibaba Qwen-32B zu konkurrieren, trotz seiner kompakten Größe. In Aufgaben zum allgemeinen Wissen wie MMLU-Pro sind seine Ergebnisse (im mittleren bis oberen 50%-Bereich) respektabel, aber nicht revolutionär, was seinen spezialisierten Fokus auf logisches Denken widerspiegelt.

Anwendungsbereiche von MiMo-7B

Die kompakte Größe und Effizienz von MiMo-7B machen es ideal für eine breite Palette von Anwendungen, insbesondere auf Geräten mit begrenzten Ressourcen:

- Bildung: Unterstützung bei der schrittweisen Lösung mathematischer Probleme und Programmier-Tutorials zur Verbesserung der Lernergebnisse.

- Softwareentwicklung: Automatisierung der Code-Fehlerbehebung, Algorithmusoptimierung und Erstellung von Unit-Tests.

- Forschung: Unterstützung bei automatisierten Theorembeweisen, logischer Analyse und datenbasierten Hypothesentests.

- Edge Computing: Ausführung von Denkprozessen auf IoT-Geräten, Smartphones und anderen Systemen mit begrenzten Ressourcen.

- Automatisierung im Unternehmen: Anwendungen in Finanzen, Gesundheitswesen und Logistik, wo logisches Denken entscheidend ist.

Die Integration von MiMo-7B in Xiaomis Ökosystem, einschließlich HyperOS und dem Assistenten Xiao AI, verspricht eine verbesserte Intelligenz von Geräten wie Smartphones, Smart-Homes und Elektrofahrzeugen wie dem Xiaomi SU7.

Open Source: Ein Schub für die Community

Xiaomi hat MiMo-7B unter der Apache 2.0-Lizenz veröffentlicht, wodurch dessen Nutzung, Modifikation und kommerzielle Anwendung uneingeschränkt möglich ist. Modelle und technische Dokumentation sind verfügbar auf:

- Hugging Face: Repositories wie XiaomiMiMo/MiMo-7B-RL und MiMo-VL-7B-RL.

- GitHub: Enthält Checkpoints für alle Versionen (Base, SFT, RL-Zero, RL).

Diese Entscheidung fördert nicht nur die Zusammenarbeit in der Community, sondern positioniert Xiaomi auch als wichtigen Akteur bei der Demokratisierung der KI. Entwickler und Enthusiasten können mit MiMo-7B experimentieren, zu seiner Verbesserung beitragen und die Innovation in diesem Bereich beschleunigen.

Vergleich mit anderen Modellen

| Merkmal | MiMo-7B-RL | OpenAI o1-mini | Alibaba Qwen-32B |

|---|---|---|---|

| Parameter | 7 Milliarden | Nicht spezifiziert (geschätzt >20B) | 32 Milliarden |

| Mathematisches Denken | 95,8% (MATH-500), 68,2% (AIME 2024) | Vergleichbar in AIME 2024 | Schlechter in AIME 2024 |

| Codegenerierung | 57,8% (LiveCodeBench v5) | Vergleichbar in LiveCodeBench | Schlechter in LiveCodeBench |

| Modellgröße | Kompakt, geeignet für Edge Computing | Größer, benötigt mehr Ressourcen | Größer, benötigt mehr Ressourcen |

| Lizenz | Apache 2.0 (Open Source) | Proprietär | Proprietär |

| Training | 25 Billionen Tokens, optimiertes RL | Nicht veröffentlicht | Nicht veröffentlicht |

Herausforderungen und Chancen

Herausforderungen

- Konkurrenz: Obwohl MiMo-7B größere Modelle in bestimmten Aufgaben übertrifft, liegt es im allgemeinen Denken hinter Spitzensystemen wie Google Gemini 2.0 zurück.

- Markenwahrnehmung: Xiaomi muss seine Wahrnehmung als vorwiegend Hardware-Unternehmen überwinden, um sich als KI-Leader zu etablieren.

- Skalierbarkeit: Die Aufrechterhaltung der Leistung in realen Anwendungen erfordert kontinuierliche Verbesserungen bei Training und Infrastruktur.

Chancen

- Integriertes Ökosystem: Die Integration von MiMo-7B in Xiaomi-Geräte (Smartphones, IoT, Fahrzeuge) eröffnet neue Möglichkeiten für vernetzte Erlebnisse.

- Open-Source-Community: Die Veröffentlichung des Modells fördert die globale Zusammenarbeit, zieht Talente an und beschleunigt die Entwicklung.

- Schwellenländer: Die Effizienz von MiMo-7B macht es ideal für Regionen mit begrenzter technologischer Infrastruktur.

Fazit

MiMo-7B stellt einen Meilenstein in Xiaomis Strategie dar, ein führender Akteur im Bereich der Künstlichen Intelligenz zu werden. Mit seinem Fokus auf logisches Denken, seiner kompakten Größe und seiner Open-Source-Verfügbarkeit bricht dieses Modell mit den Normen der Branche und beweist, dass Intelligenz nicht allein von der Größe abhängt. Von der Unterstützung von Schülern in Mathematik bis zur Optimierung der Softwareentwicklung hat MiMo-7B das Potenzial, zahlreiche Sektoren zu verändern. Mit der fortschreitenden Integration in Xiaomis Ökosystem und der weltweiten Akzeptanz durch die Community wird MiMo-7B ein wichtiger Bestandteil der KI-Entwicklung im Jahr 2025 und darüber hinaus sein.